高效日志管理与监控

- Published on

目录

在现代软件开发中,有效的日志管理和系统监控对于维护应用程序的健康和性能至关重要。本文将深入探讨如何利用Django、ELK Stack (Elasticsearch、Logstash、Kibana) 以及Prometheus和Grafana构建一个全面的日志管理和监控系统。

1. Django日志管理

Django提供了强大而灵活的日志记录功能,基于Python的内置logging模块。通过正确配置,您可以轻松管理应用程序的日志输出。

1.1 Django日志配置

在Django项目的settings.py文件中,您可以通过LOGGING字典来配置日志系统。以下是一个更全面的配置示例:

LOGGING = {

'version': 1,

'disable_existing_loggers': False,

'formatters': {

'verbose': {

'format': '{levelname} {asctime} {module} {process:d} {thread:d} {message}',

'style': '{',

},

'simple': {

'format': '{levelname} {message}',

'style': '{',

},

},

'filters': {

'require_debug_true': {

'()': 'django.utils.log.RequireDebugTrue',

},

},

'handlers': {

'console': {

'level': 'INFO',

'filters': ['require_debug_true'],

'class': 'logging.StreamHandler',

'formatter': 'simple'

},

'file': {

'level': 'WARNING',

'class': 'logging.FileHandler',

'filename': '/path/to/django/logs/warning.log',

'formatter': 'verbose'

},

},

'loggers': {

'django': {

'handlers': ['console', 'file'],

'level': 'INFO',

},

'django.server': {

'handlers': ['console'],

'level': 'INFO',

'propagate': False,

},

'myapp': {

'handlers': ['console', 'file'],

'level': 'WARNING',

'propagate': True,

},

}

}

这个配置提供了以下功能:

- 定义了两种格式化器:

verbose和simple。 - 设置了控制台和文件两种日志处理器。

- 为Django框架和自定义应用(

myapp)配置了不同的日志记录器。

1.2 在Django中使用日志

在Django应用中使用日志非常简单。以下是一个示例视图:

import logging

from django.http import HttpResponse

logger = logging.getLogger(__name__)

def sample_view(request):

logger.info("Access to sample view")

try:

# Some operation

result = perform_complex_operation()

except Exception as e:

logger.error(f"An error occurred: {str(e)}", exc_info=True)

return HttpResponse("An error occurred", status=500)

logger.debug(f"Operation result: {result}")

return HttpResponse("Operation completed successfully")

这个视图演示了如何在不同的日志级别记录信息,包括错误处理和调试信息。

2. ELK Stack: 高级日志管理解决方案

ELK Stack(现称为Elastic Stack)是一个开源的日志管理和分析平台,由三个主要组件组成:Elasticsearch、Logstash和Kibana。它被广泛用于收集、存储、搜索和可视化日志数据,帮助用户从不同来源聚合和分析信息。以下是对ELK Stack的详细介绍,包括其功能、安装步骤和使用案例。

2.1 Elasticsearch

Elasticsearch是一个分布式的搜索和分析引擎,能够处理大量的结构化和非结构化数据。它基于Lucene构建,提供实时的搜索和分析功能。Elasticsearch以文档的形式存储数据,支持复杂的查询和聚合操作。

关键特性:

- 分布式架构,支持横向扩展

- 近实时搜索和分析

- 支持结构化和非结构化数据

- 强大的全文搜索能力

- RESTful API,易于集成

安装和基本配置:

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-7.15.0-linux-x86_64.tar.gz

tar -xzf elasticsearch-7.15.0-linux-x86_64.tar.gz

cd elasticsearch-7.15.0/

编辑config/elasticsearch.yml:

cluster.name: my-application

node.name: node-1

network.host: 0.0.0.0

http.port: 9200

discovery.seed_hosts: ["127.0.0.1"]

cluster.initial_master_nodes: ["node-1"]

启动Elasticsearch:

./bin/elasticsearch

基本操作:

创建索引:

PUT /my-index添加文档:

POST /my-index/_doc { "title": "Log entry", "message": "Application started", "timestamp": "2023-08-17T10:00:00Z" }搜索:

GET /my-index/_search { "query": { "match": { "message": "started" } } }

2.2 Logstash

Logstash是一个数据处理管道,可以从多个来源收集数据,进行过滤和转换,然后将其发送到Elasticsearch或其他存储系统。它支持多种输入、过滤和输出插件,能够处理多种格式的数据。

关键特性:

- 支持多种输入源(文件、syslog、metrics等)

- 强大的过滤器功能,支持数据转换和丰富

- 可扩展的插件生态系统

- 可靠的数据缓冲机制

配置Logstash:

创建一个更复杂的logstash.conf文件:

input {

file {

path => "/var/log/nginx/access.log"

start_position => "beginning"

}

tcp {

port => 5000

codec => json

}

}

filter {

if [path] =~ "access" {

grok {

match => { "message" => "%{COMBINEDAPACHELOG}" }

}

date {

match => [ "timestamp" , "dd/MMM/yyyy:HH:mm:ss Z" ]

}

}

if [type] == "django" {

grok {

match => { "message" => "%{LOGLEVEL:log_level} %{TIMESTAMP_ISO8601:timestamp} %{GREEDYDATA:message}" }

}

date {

match => [ "timestamp", "ISO8601" ]

}

}

mutate {

add_field => { "environment" => "production" }

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "logstash-%{+YYYY.MM.dd}"

}

stdout { codec => rubydebug }

}

这个配置文件展示了如何:

- 从Nginx访问日志和Django应用收集日志

- 使用Grok过滤器解析不同格式的日志

- 使用Date过滤器处理时间戳

- 使用Mutate过滤器添加额外字段

- 将处理后的日志发送到Elasticsearch和标准输出

2.3 Kibana

Kibana是一个数据可视化工具,允许用户通过图表、仪表板和其他可视化组件来分析和展示存储在Elasticsearch中的数据。Kibana提供了丰富的用户界面,帮助用户快速理解和探索数据。

关键特性:

- 实时数据可视化

- 支持多种图表类型(折线图、柱状图、饼图等)

- 强大的仪表板创建功能

- 内置的开发工具,用于与Elasticsearch交互

- 支持地理空间数据分析

安装和配置Kibana:

wget https://artifacts.elastic.co/downloads/kibana/kibana-7.15.0-linux-x86_64.tar.gz

tar -xzf kibana-7.15.0-linux-x86_64.tar.gz

cd kibana-7.15.0/

编辑config/kibana.yml:

server.port: 5601

server.host: "0.0.0.0"

elasticsearch.hosts: ["http://localhost:9200"]

启动Kibana:

./bin/kibana

使用Kibana:

访问Kibana界面:

http://localhost:5601创建索引模式:

- 导航到 Management > Stack Management > Kibana > Index Patterns

- 创建一个新的索引模式,如

logstash-*

创建可视化:

- 在 Visualize 中选择图表类型

- 选择索引模式和字段

- 配置图表参数

创建仪表板:

- 在 Dashboard 中创建新仪表板

- 添加之前创建的可视化

- 排列和调整大小

使用Discover进行数据探索:

- 使用Lucene查询语法或Kibana查询语言(KQL)搜索数据

- 查看原始日志数据和字段统计信息

3. Prometheus和Grafana: 实时监控解决方案

Prometheus和Grafana组合提供了强大的实时监控和报警能力,特别适合于监控微服务架构和云原生应用。

3.1 Prometheus

Prometheus是一个开源的监控和报警系统,主要用于收集和存储时间序列数据。其工作原理如下:

- 数据采集:Prometheus使用"pull"模型,定期从被监控的目标(如应用程序、服务器等)抓取指标数据。每个目标需要暴露一个HTTP接口,提供其指标数据。

- 数据存储:Prometheus将抓取到的数据存储在本地时序数据库中,支持高效的查询和聚合操作。

- 查询语言:Prometheus使用PromQL(Prometheus Query Language)进行数据查询,用户可以通过PromQL对存储的数据进行复杂的查询和计算。

- 报警功能:Prometheus还支持报警功能,可以根据设定的规则触发报警,并通过Alertmanager进行管理和通知。

安装和配置Prometheus:

wget https://github.com/prometheus/prometheus/releases/download/v2.30.3/prometheus-2.30.3.linux-amd64.tar.gz

tar xvfz prometheus-2.30.3.linux-amd64.tar.gz

cd prometheus-2.30.3.linux-amd64/

创建更详细的prometheus.yml配置文件:

global:

scrape_interval: 15s

evaluation_interval: 15s

alerting:

alertmanagers:

- static_configs:

- targets:

# - alertmanager:9093

rule_files:

# - "first_rules.yml"

# - "second_rules.yml"

scrape_configs:

- job_name: 'prometheus'

static_configs:

- targets: ['localhost:9090']

- job_name: 'django'

static_configs:

- targets: ['localhost:8000']

- job_name: 'node_exporter'

static_configs:

- targets: ['localhost:9100']

启动Prometheus:

./prometheus --config.file=prometheus.yml

使用Prometheus:

访问Prometheus Web UI:

http://localhost:9090使用PromQL查询数据,例如:

- 查询HTTP请求总数:

http_requests_total - 按状态码分组的HTTP请求数:

sum(http_requests_total) by (status_code) - 最近5分钟的请求率:

rate(http_requests_total[5m])

- 查询HTTP请求总数:

配置警报规则:

创建alert_rules.yml:

groups:

- name: example

rules:

- alert: HighRequestLatency

expr: job:request_latency_seconds:mean5m{job="django"} > 0.5

for: 10m

labels:

severity: warning

annotations:

summary: High request latency on {{ $labels.instance }}

description: Django has a high request latency on instance {{ $labels.instance }} for more than 10 minutes.

更新prometheus.yml以包含这个规则文件:

rule_files:

- "alert_rules.yml"

3.2 在Django中集成Prometheus

使用django-prometheus库来集成Prometheus:

pip install django-prometheus

在settings.py中添加:

INSTALLED_APPS = [

...

'django_prometheus',

]

MIDDLEWARE = [

'django_prometheus.middleware.PrometheusBeforeMiddleware',

...

'django_prometheus.middleware.PrometheusAfterMiddleware',

]

在urls.py中添加:

from django.urls import path, include

urlpatterns = [

...

path('', include('django_prometheus.urls')),

]

这将在/metrics路径上暴露Prometheus指标。

3.3 Grafana

Grafana是一个开源的可视化工具,专门用于展示和分析时间序列数据。它的工作原理如下:

- 数据源支持:Grafana支持多种数据源,包括Prometheus、Graphite、InfluxDB等。用户可以将Prometheus作为数据源添加到Grafana中。

- 仪表盘和面板:用户可以创建仪表盘(Dashboard),在仪表盘中添加多个面板(Panel),每个面板可以展示不同的数据和可视化效果(如图表、饼图等)。

- 交互式查询:Grafana提供了友好的用户界面,用户可以通过查询编辑器编写PromQL查询,实时获取数据并进行可视化。

安装和配置Grafana:

wget https://dl.grafana.com/oss/release/grafana-8.1.5.linux-amd64.tar.gz

tar -zxvf grafana-8.1.5.linux-amd64.tar.gz

cd grafana-8.1.5/

编辑conf/defaults.ini或创建custom.ini:

[server]

http_port = 3000

[security]

admin_user = admin

admin_password = your_secure_password

启动Grafana:

./bin/grafana-server

使用Grafana:

访问Grafana Web UI:

http://localhost:3000添加Prometheus数据源:

- 导航到 Configuration > Data Sources

- 选择 Prometheus

- 设置URL为

http://localhost:9090 - 保存并测试

创建仪表板:

- 点击 "+" 图标,选择 "Dashboard"

- 添加新面板

- 选择Prometheus数据源

- 使用PromQL查询数据,如

rate(http_requests_total[5m]) - 配置图表类型和样式

导入预制仪表板: Grafana社区提供了许多预制的仪表板,您可以导入它们来快速开始:

- 在Grafana.com上浏览仪表板

- 复制仪表板ID

- 在Grafana中,转到 Create > Import 并粘贴ID

设置警报:

- 在面板编辑视图中,转到 "Alert" 选项卡

- 配置警报条件,如 "当最近5分钟的平均请求率超过100时触发"

- 设置通知渠道(电子邮件、Slack等)

通过结合使用ELK Stack和Prometheus + Grafana,您可以构建一个全面的日志管理和性能监控系统。ELK Stack主要用于日志聚合和分析,而Prometheus + Grafana更适合于实时性能监控和报警。这两个系统相互补充,可以为您的应用程序提供全方位的可观察性。

4. 整合使用

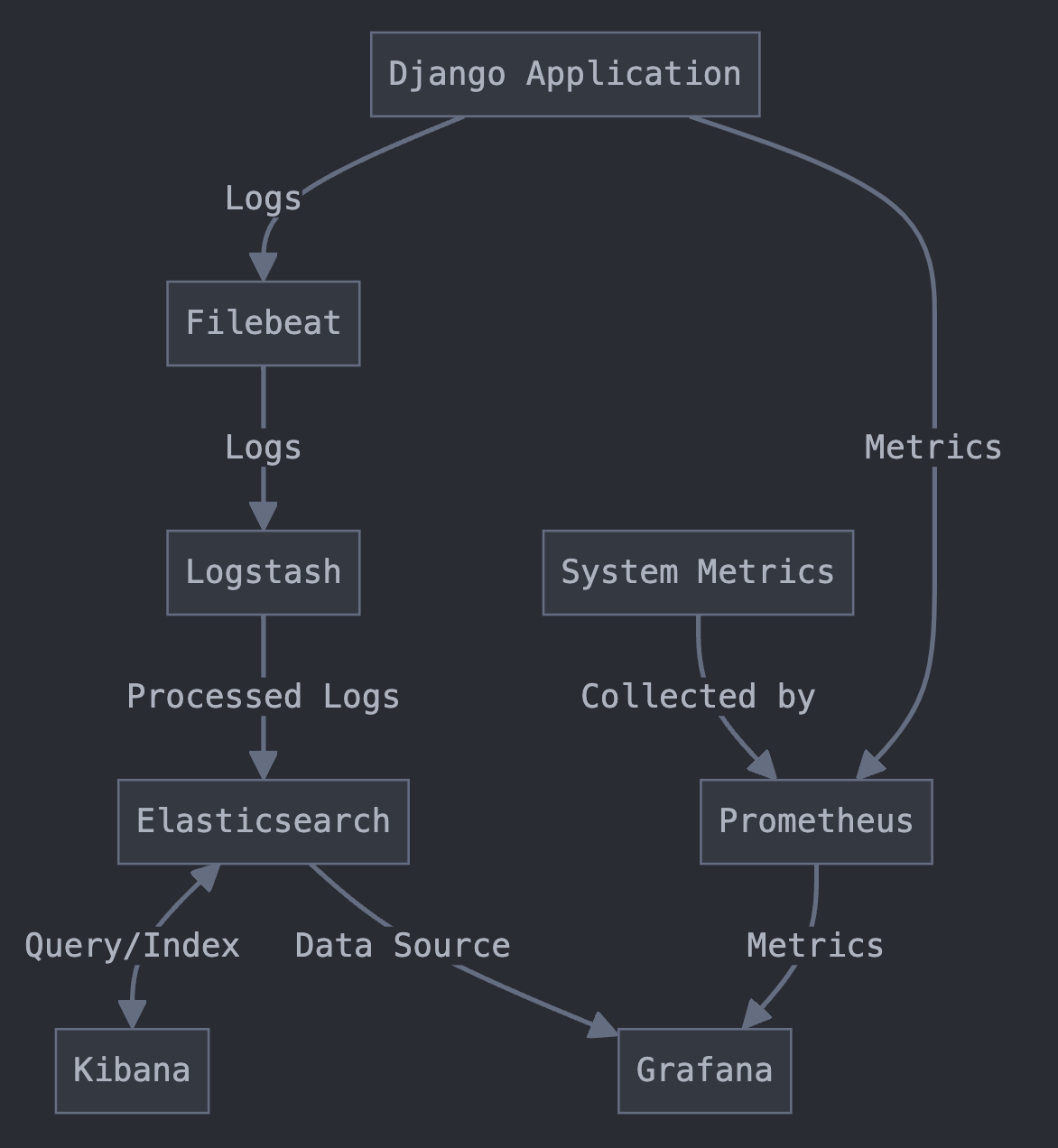

将Django、ELK Stack和Prometheus + Grafana整合在一起,可以构建一个全面的日志管理和监控系统。

4.1 Django配置

更新Django的settings.py以使用Logstash发送日志:

LOGGING = {

...

'handlers': {

'logstash': {

'level': 'INFO',

'class': 'logstash.TCPLogstashHandler',

'host': 'localhost',

'port': 5000,

'version': 1,

'message_type': 'django',

'fqdn': False,

'tags': ['django'],

},

},

'loggers': {

'django': {

'handlers': ['logstash'],

'level': 'INFO',

},

},

}

4.2 数据流

- Django应用生成日志

- 日志被发送到Logstash

- Logstash处理日志并发送到Elasticsearch

- Kibana从Elasticsearch读取数据并可视化

- Prometheus从Django应用抓取性能指标

- Grafana从Prometheus读取数据并创建仪表板

5. 最佳实践

结构化日志: 使用结构化的日志格式(如JSON)可以更容易地进行解析和分析。

合适的日志级别: 合理使用不同的日志级别(DEBUG, INFO, WARNING, ERROR, CRITICAL)。

上下文信息: 在日志中包含足够的上下文信息,如请求ID、用户ID等。

性能考虑: 注意日志记录对应用性能的影响,避免在高频调用的代码路径中使用过多的日志。

安全性: 确保敏感信息不会被记录到日志中。

定期回顾: 定期审查日志和监控数据,以识别潜在的问题和优化机会。

报警配置: 合理配置Prometheus的报警规则,避免误报和漏报。

通过实施这些工具和最佳实践,您可以构建一个强大的日志管理和监控系统,提高应用程序的可观察性和可维护性。这不仅有助于快速诊断和解决问题,还能为性能优化和容量规划提供宝贵的见解。